前言 K8S原生Deployment支持滚动更新和重建两种发布模式。 滚动更新模式 Pod升级自动进行,失败自动暂停。通过以下策略控制升级速率: Max Unavailable : 最大不可用实例数/比例 Max Surge : 调度过程中,可超过期望实例数的数/比例 然而,由于发布期间无法暂停,导致没有时间验证新版本正确性,仅依赖Pod Read…

问题背景 在学习开源项目时,很多时候光看代码是搞不清楚实际运行时会走哪个逻辑分支,或者无法推测方法参数值。最简单的办法是 debug,熟悉某个功能的执行流程。 我们通常用 delve 去 debug golang 程序,但是很多云原生项目运行在 k8s 环境里,在本地我们可以用 minikube 来模拟 k8s。两者结合产生新问题:如何 debug…

K8s 如何通过 kubeproxy 保证两个 Pod 之间的相互通信? kubeproxy 会监听 pod 的变化,在 node 上配置 iptables规则,将访问的 service ip,做 DNAT,转到 service 负载均衡的endpoint ip。但是 iptables 查找负载均衡的 endpoint 是 O(n)复杂度,当集群 …

需求背景 服务 A 部署在 K8S 中,集群外的服务 B 需要调用服务 A,同时调用服务 A 的端口是指定了的,必须是 5000,无法修改。 K8S 集群是客户的,我们只能部署服务,不能修改集群。 服务 A 需要得到真实的客户端 IP。 解决方案一 通过 Nodeport 的方式暴漏服务 A。 5000 端口不在 Nodeport 默认端口范围内(…

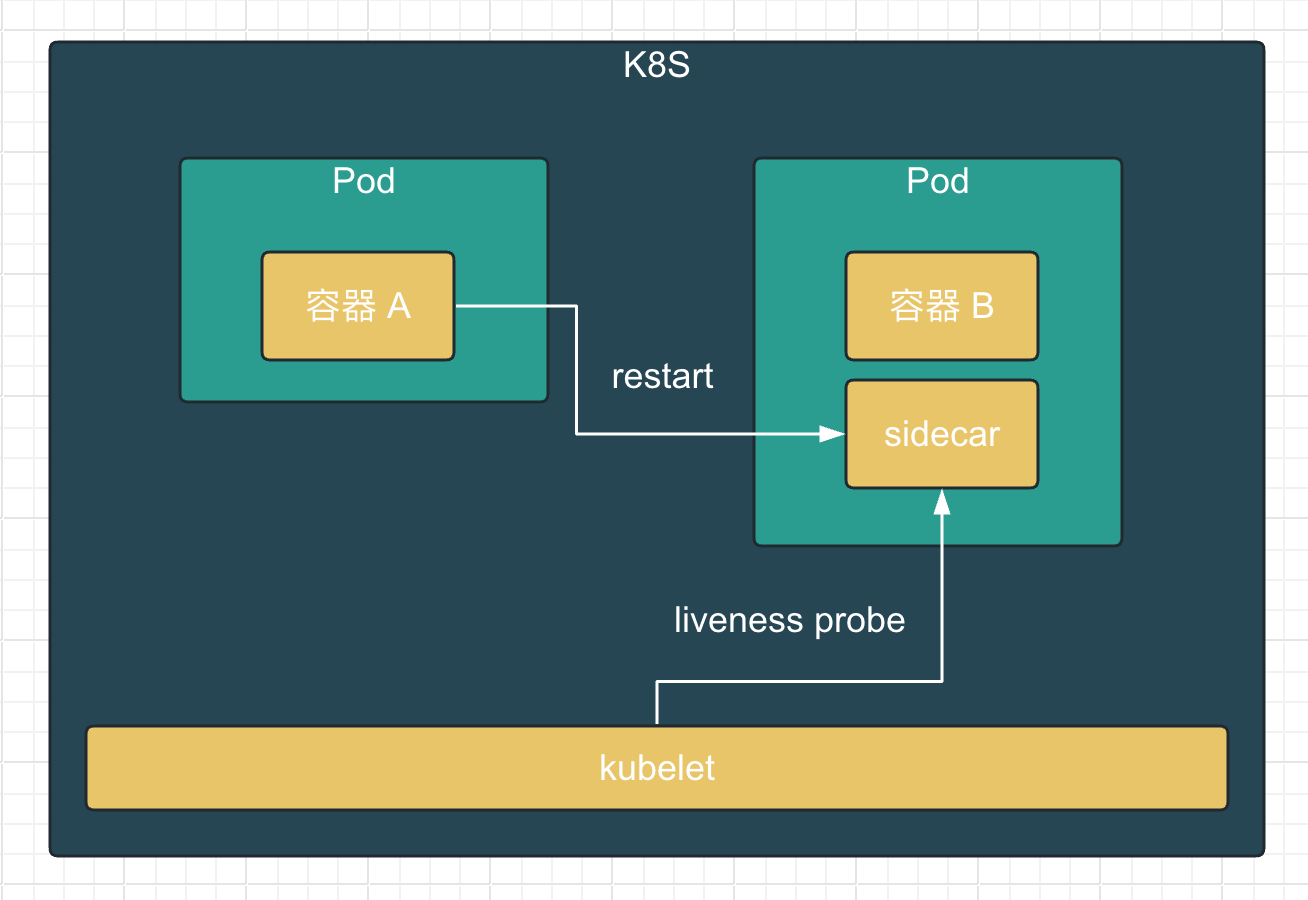

需求一 A 容器负责授权管理,当用户更改了授权时,需要重启 B 容器生效。 解决方案 通过 sidecar 启动一个 http server,并提供两个接口,接口一用于 K8S 的存活探针;接口二用于接收重启信号,供容器 A 调用。当收到重启信号时,修改接口一返回值,使其返回 500 http code,从而让 K8S 重启 Pod 内容器。 方案…

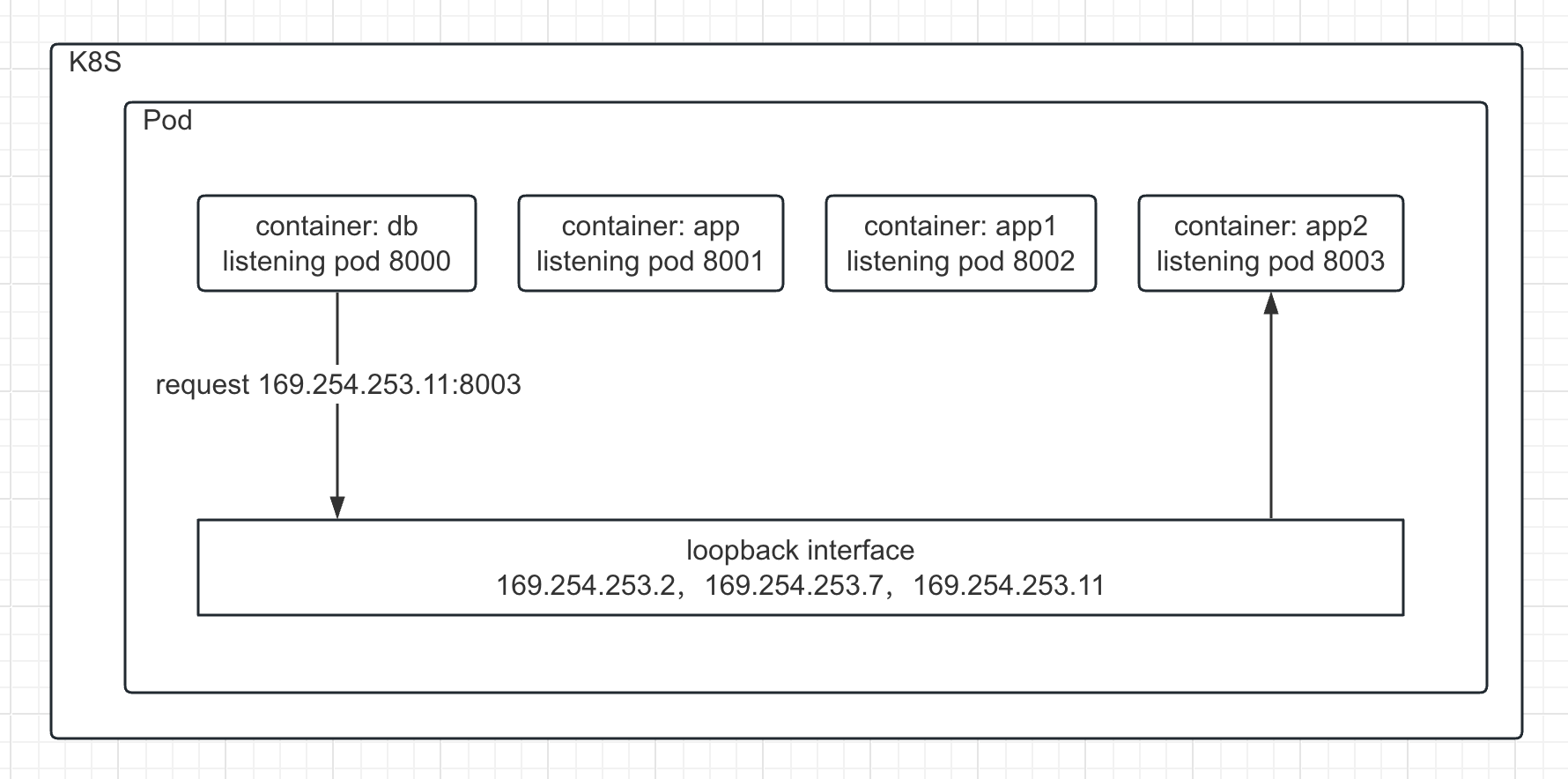

背景 最近遇到一个docker compose部署的产品(旧版本)想部署到k8s中,而该产品应用的多个容器都在docker compose中设置了ip地址,镜像里的应用配置也是配置的这些预设ip,容器之间通过预设IP进行通信。 但是该产品的云化已经在最新版本中完成,并做了大量修改。现在希望对那个旧版本以最小成本部署到k8s中就行,也就是不想动产品应…

背景 还是之前的需求,上一篇文章:Operator示例:通过Operator+CRD实现部署自动化是基于官方的sample-controller来修改,实现我们的逻辑。这次使用kubebuilder来生成代码。 主要步骤 使用kubebuilder生成项目代码 定义 CRD 的 struct 重新生成CRD资源 实现Reconcile逻辑 部署CR…

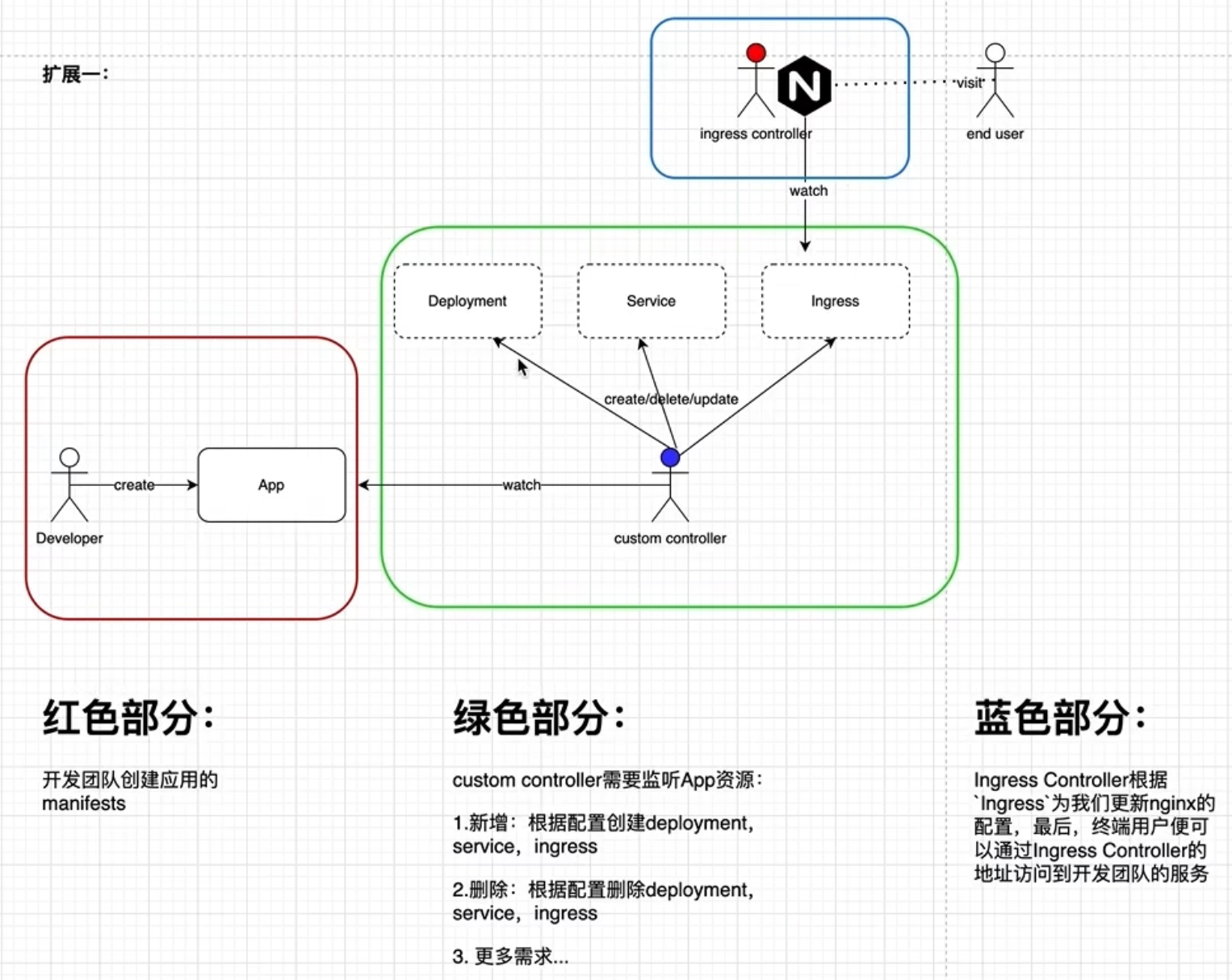

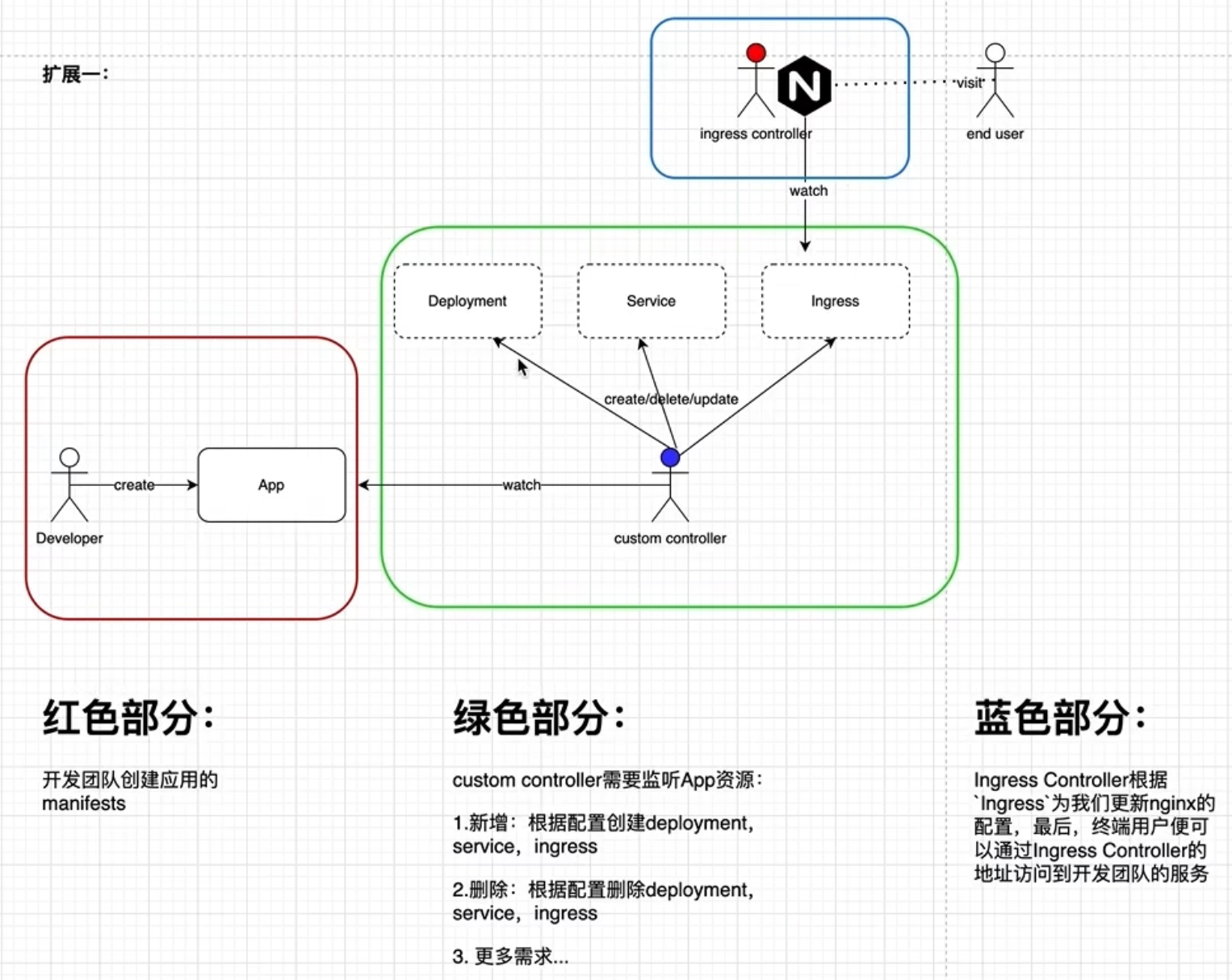

前言 在上一篇通过Operator自动暴露集群内部服务中,遗留了一个问题:开发人员or业务上游是需要关注k8s内建资源,例如deployment如何定义,这和K8S自动化的目标背道而驰。 本篇文章将采用CRD(CustomResourceDefinition)来屏蔽底层K8S资源,让开发人员只需要按照我们制定的规则来定义CR即可。至于创建deplo…

需求背景 运维团队希望管控部署在k8s集群里对外暴露的服务,开发团队无需关心服务如何暴露给用户。 红色部分 开发团队创建应用的manifests,开发团队可以为Service:资源添加annotation为ingress/http:true来决定终端用户是否可以访问到该服务,默认不能访问到。至于具体如何让用户可以访问到服务,开发团队不需要关心。 绿…

client-go 架构图 Indexer原理 Indexer缓存k8s资源对象,并提供便捷的方式查询。例如获取某个namespace下的所有资源 indexer接口继承了store接口,所以indexer的实现类也是store的实现类。add方法被调用的地方和store一样,是reflector调用的。 type Indexer interfac…